Ротапост выбрал 7 вещей, которые нужно сделать в Минусинске. Шутка.

15 апреля 2015 года Яндекс представил новый алгоритм. Его назвали Минусинск в честь города, который отмечает, к примеру, День помидора, и этот алгоритм призван бороться с покупными ссылками. Минусинск запустят 15 мая, а эксперты SEO, кажется, уже знают, что делать.

Кто-то советует ни в коем случае не снимать покупные ссылки, потому что это будет сигнал для Яндекса о том, что они у вас есть. Кто-то считает, что снять надо только арендные ссылки, а вечные, как в Ротапост, оставить.

Решили разобраться в вопросе подробнее.

Что такое поисковая система

Это программно-аппаратный комплекс, созданный для обеспечения поиска информации в интернете.

Аппаратная часть поисковой системы представляет собой множество мощных серверов, распределенных географически, и обеспечивающих работу программных модулей и хранение информации о web-страницах и сайтах.

Программная часть поисковой системы называется поисковой машиной. Ею мы и пользуемся каждый день. А наши родители называют ее Интернетом. Поисковая машина – сложная система из множества модулей, большинство ее алгоритмов является коммерческой тайной и не раскрываются пользователям. Однако, некоторые механизмы общеизвестны.

Упрощенно, любая поисковая система подразделяется на 3 модуля:

- Краулер,

- База данных.

- Механизм ранжирования.

Краулер

Краулер, часто называемый “паук” или просто “робот”, это модуль, сканирующий интернет. Он обходит интернет-сайты и скачивает содержимое их страниц. После скачивания краулер отфильтровывает контент, который не представляет для него интереса.

У каждой поисковой системы свой набор пауков. Самый важный из них – индексный. Он переходит по ссылкам на сайтах, сканирует исходный код и сохраняет текстовое содержимое, отбрасывая все лишнее (html-код, скрипты, изображения).

Для обработки других видов информации существуют другие краулеры – одни сохраняют графику для поиска по изображениям, другие ищут и склеивают зеркала (копии) сайтов, некоторые просто проверяют работоспособность страниц.

База данных

Загруженный пауком текст разбивается на слова, и информация о web-странице и всех вхождениях слов на ней заносится в базу данных. При этом слова хранятся в базе в упрощенном, приведенным к “основам”, виде. Основу можно сравнить с самой просто словоформой, например, единственное число именительный падеж.

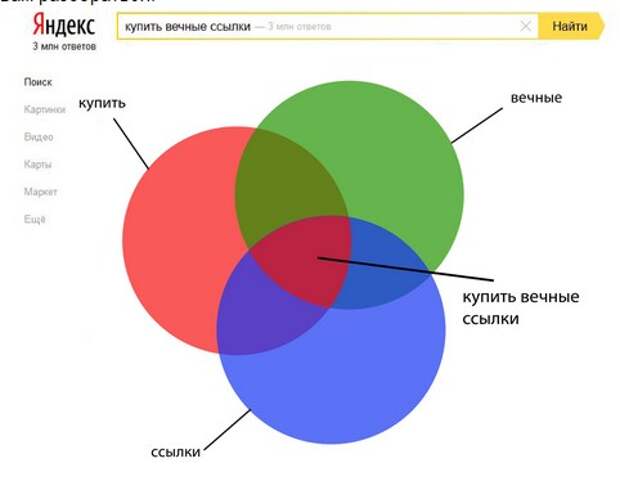

Таким образом формируется индекс – множество таблиц, в которых ключевым полем является основа слова, и для каждой основы хранятся данные о ее вхождении на различных страницах. Индексация – процесс занесения страницы в индекс по содержащимся на ней словам. Когда мы вводим запрос из нескольких слов, поисковая система отображает страницы, информация о которых присутствует одновременно по всем основам слов запроса. Это может показаться сложным, но простая диаграмма поможет вам разобраться:

Механизм ранжирования

Когда пользователь обращается к поисковой системе с запросом, он ожидает увидеть результаты, которые смогли бы удовлетворить его потребности, то есть были им релевантны. Проблема заключается в том, что подходящих сайтов бывает очень много, а страница результатов поиска ограничена (обычно 10 ссылками).

Чтобы определить, в каком порядке ранжировать (упорядочивать) ссылки и используется механизм ранжирования. Чтобы обеспечить максимальную релевантность, поисковые системы постоянно его улучшают и вводят новые поисковые технологи.

На результаты поиска Яндекса оказывает влияние множество алгоритмов – это и механизм машинного обучения “Матрикснет”, и технология “Спектр”, призванная снять неоднозначность запроса, и алгоритм “Калининград”, предназначенный чтобы показать каждому пользователю персональную, созданную исходя из его интересов, выдачу.

При ранжировании механизм использует сотни и тысячи факторов, таких как географическая привязка, удобство сайта для пользователей, скорость его работы. Без ссылок никуда, поэтому одними из первых и самых значимых факторов являются оптимизированность контента сайта и его ссылочная популярность.

Под оптимизацией контента понимают создание текста и прочего контента исходя из потребностей пользователей и включение в него ключевых слов (т.е. слов запроса).

Ссылочная популярность и почему поисковая система не сможет работать без ссылок

Кроме текста, изображений и прочего контента, поисковые системы также индексируют ссылки. Ссылки помогают поисковой системе находить новые страницы для индексации, а также определять наиболее значимые страницы.

Сразу после появления в Яндекс механизма учета ссылок ссылочная популярность считалась очень просто – чем больше ссылок поставили на страницу, тем она авторитетнее. Недобросовестные вебмастера пользовались слабыми алгоритма, продвигая в ТОП ссылками некачественные и даже мошеннические сайты.

Чтобы усложнить спамерам задачу, был введен критерии тематичности ссылки. То есть, теперь, чтобы продвинуть сайт нужно получать ссылки с сайтов той же тематики что и ваш. Кроме того, были введены критерии ссылочной популярности, которые сделали сайты и страницы не равнозначными – чем больше ссылок ведет на страницу, тем полезнее она в продвижении.

В дальнейшем Яндекс совершенствовал свои алгоритмы борьбы со ссылочным спамом, добавляя все больше и больше критериев, и, на сегодняшний день, получить естественную ссылку стало гораздо сложнее.

Актуальные критерии естественности и эффективности ссылки:

- По ссылке есть переходы пользователей. То есть она интересна реальным людям.

- Ссылка должна располагаться на сайте, близком к вашему по тематике. К примеру, если один строительный сайт ссылается на другой, где более подробно раскрыта какая-либо тема, это естественно. Такая ссылка не будет спамом, так как пользователям она будет интересна.

- Сайт должен быть посещаем и иметь много проиндексированных страниц. Зачастую эти параметры связаны, и, при примерно равных параметрах, более посещаемым будет тот сайт, который лучше проиндексирован. Если очевидно, что на сайте много страниц, но в индексе находится лишь пара процентов из них, вероятно и ваша ссылка продержится в индексе не долго.

- Не только весь сайт, но и страница со ссылкой должна быть близка по теме к вашему сайту.

- Должно быть понятно, что текст – именно ссылка. То есть ссылка должна отличаться от обычного текста стилем (обычно используется подчеркивание, другой цвет или шрифт). Если ссылка неотличима для человека от окружающего текста, по ней не будет переходов. А для поисковой системы это будет признаком того что ссылка поставлена только для влияния на выдачу.

- Ссылка должна находится там, где ее видят. Наиболее естественным расположением ссылки является область контента, когда ссылка размещена в статье.

Сайдбары (колонки справа и слева от контента) обычно предназначены для меню, баннеров и виджетов, располагать там ссылки менее предпочтительно.

Наихудшим местом для размещения ссылки является футер. И людям и поисковикам очевидно, что ссылка в футере, написанная мелким шрифтом размещена только для передачи ссылочного веса. - Ссылка появилась вместе со страницей. Если на вашем сайте на протяжении месяцев, а может и лет размещалась статья без ссылок, и в один момент вы добавили в нее одну или пару, авторитет таких ссылок будет меньше, чем у ссылки в новой статье.

- Ссылка не “мигает”. Как мы уже говорили, краулер посещает страницы по несколько раз. Если от посещения к посещению ссылки на страницах то появляются то пропадают, как это бывает со ссылками поставленными автоматически, поисковая система отметит их как спам, и снизит или нивелирует их влияние.

Какие сайты будут отнесены к спамным

На сайтах хотя бы с одним из следующих признаков точно не стоит закупать ссылки:

- Количество страниц в индексе намного меньше чем всего на сайте. Сайту уже несколько лет, на нем 1-2 тысячи статей, но в индексе их всего несколько десятков.

- Количество страниц в индексе Яндекса или посещаемость сайта равна нулю.

- Количество получателей, то есть различных сайтов, на которые анализируемый сайт поставил ссылки, во сотни раз больше, чем количество тех, кто поставил ссылки на него.

- Количество внешних ссылок составляет больее 50% от количества страниц в индексе Яндекс. При этом не следует учитывать “сквозные ссылки”, то есть те, которые размещены в одном месте на всех страницах. Например, у сайта в индексе 1000 страниц, при этом на каждой странице в шапке размещены 3 ссылки на группы сайта в социальных сетях, таким образом в сумме давая 3000 внешних ссылок, это не повредит репутации. Но, если на 800 из 1000 страниц поставлены ссылки (особенно текстовые) на разные сайты, такой сайт наверняка будет признан спамным.

- тИЦ сайт не определяется. На этот сайт поисковой системой Яндекс уже были наложены санкции.

- Дизайн, юзабилити и контент сайта вызывают сильные сомнения. Контент некачественный, возможно генерированный автоматически, ориентироваться по сайту практически невозможно из-за отсутствия юзабилити. Даже если при этом сайт обладает хорошими показателями посещаемости и/или тИЦ, ставить ссылку на таком сайте не следует, так как показатели могут быть “накручены” искусственно.

Девака и uplab спросили у известных оптимизаторов, что будет и как поступить со ссылками.

Нам понравился второй формат, поэтому пошли к основателю Ротапост Дмитрию Голополосову и задали ему те же вопросы, что и uplab задавало другим экспертам SEO.

Как ты считаешь, насколько сильно новый алгоритм затронет поисковую выдачу Яндекса?

Гадать на эту тему — дело неблагодарное. В данном случае я абсолютно солидарен с Сергеем Людкевичем: если выдача не сильно изменится, то и методы работы оптимизаторов мало чем будут отличаться от текущих.

У Яндекса уже традиция: пугать сильнее, чем реально делать. Я не думаю, что сильно изменится выдача.

По наблюдениям оптимизаторов, в прошлый раз кардинальных изменений не было, ссылки как покупались, так и покупаются. Сейчас будет по-другому?

Я не жду больших потрясений в выдаче. Все останется примерно на том же месте. Безусловно, будут сайты, которые пострадают (и самые большие шансы у тех, кто уже получил письма счастья в вебмастерс).

С чем может быть связан новый алгоритм? С тем, что прошлый не взлетел? А сейчас взлетит?

Алгоритм, судя по всему, является логическим продолжением предыдущего, возможно, обновленным взглядом с учетом допущенных ошибок. Вообще, я не думаю, что к алгоритмам ранжирования стоит применять термин “не взлетел” — качество выдачи, как кому-то не хотелось бы, все же субъективная категория.

Ты считаешь, что этот алгоритм – то, что действительно сейчас нужно? Не стоит ли Яндексу перестать гоняться за оптимизаторами и заняться другими делами?

Яндекс занимается всем одновременно. По сути ведь это набор команд, которые развивают отдельные сервисы этого гиганта. Поиск — одно из направлений, за которым следит довольно большое сообщество специалистов, поэтому изменения всегда заметны и бурно обсуждаются.

Рома Морозов регулярно напоминаем всем, что Яндексу очень хочется зарабатывать больше на контексте, и подобные страшилки, возможно, добавляют им благодарных пользователей. Красивая версия

Что станет с рынком покупных ссылками после 15 мая? Пора всем обращаться к юзератору? И Ротапосту накручивать поведенческие начать?

Ротапост — это ведь не торговля ссылками в чистом виде  Сервис предлагает владельцу блога или новостного сайта упомянуть рекламируемую ссылку в нужном контексте в тематическом посте. Причем, что важно, ссылка должна появиться одновременно со страницей, на которой она расположена.

Сервис предлагает владельцу блога или новостного сайта упомянуть рекламируемую ссылку в нужном контексте в тематическом посте. Причем, что важно, ссылка должна появиться одновременно со страницей, на которой она расположена.

И если тематика страницы подходящая, ссылка вписана органично, то я бы не стал клеймить это “SEO-ссылкой”. Конечно, такие ссылки весьма полезны с точки зрения продвижения в поисковиках, но это не единственная их польза. Такие ссылки дают еще и трафик, что в скором времени мы планируем наглядно показывать.

Появится ли у Яндекса сервис наподобие дисаллоу линкс, как у Гугла?

Не думаю. Яндекс обычно обзывает, стебет и пытается втоптать в грязь вебмастеров. К сожалению. Гугл в этом плане ведет себя иначе — поэтому и сервисы часто развернуты лицом к вебмастерам.

Что ты посоветуешь вебмастерам: что лучше сделать сейчас, чтобы 15 мая не попасть под новый алгоритм?

Если есть возможность снять когда-либо поставленные “говноссылки” (ну то есть совсем треш), то лучше это сделать сейчас. А в остальном я считаю, что резких телодвижений совершать не стоит.

Свежие комментарии